I en publicerad understreckare i Svenska Dagbladet ifrågasätter Björn Hammarfeldt de universitetsrankningar som förekommer. Svenska universitet placerar sig sällan särskilt högt bland dessa, men Karolinska institutet är fortfarande topp 50 trots den nyligen genomlevda Macchiariniskandalen.

Hammarfeldt utgår lite överraskande från ett mer än 100 år gammalt försök från den närmast bortglömde James McKeen Cattell att rangordna amerikanska universitet. Jag ska inte här beröra det psykologihistoriska i Hammarstedts artikel, där huvudtesen är att det finns ”slående likheter mellan det tidiga 1900-talets vurm för eminenta vetenskapsmän och nutidens fokus på excellent forskning”.

Varför behöver man då rangordna universitet? En anledning – i dessa ekonomismens tider –kan vara att sådana organisationer är att likställa med större företag, som ju dagligen värderas på börsen. Då vore det rimligt att bedöma och värdera universiteten varje år, vilket sker genom rankningarna. Men det bär för många emot att utgå från företagsekonomiska kriterier. Hammarstedt menar här att universitetens traditionella roll har varit som ”bildningsinstitution”. Även de ”nya” kraven på universitet att bidra till regional utveckling, nationell innovationskraft, etcetera står i kontrast till vad Hammarfeldt uppfattar som ”excellens” inom forskning.

Att det finns en diskussion om balansen mellan hög kvalitet och tillgänglighet i frågan om tilldelningen av resurser till den högre utbildningen och forskningen är väl känt. Hammarfeldt deltog i en liknande debatt 2012 i GP med anledning av statsvetaren Bo Rothsteins påpekande att svenska samhällsvetare sällan publicerar sig och därmed inte heller citeras så ofta internationellt. Ett av många mått på kvalitet är ju hur ofta en forskargrupp citeras internationellt.

Väl att märka: då handlar det om forskargrupper, det vill säga på en relativt låg nivå i ett universitets organisation. En framgångsrik forskargrupp bör förstås belönas och ges resurser att fortsätta verka, vilket ju också sker. Det är rimligt att tilldelningen av resurser går till de universitetsinstitutioner som har hög kvalitet.

Hur går då rankningen av universitet och deras institutioner till i dag? USA:s National Council of Research, NRC, använder sig av fem breda rankningsvariabler:

- S-Rank: professionella forskare från doktorander till professorer rankar utifrån sina kriterier.

- Forskning: baseras på publikationer, citeringar, anslag som beviljats och utmärkelser.

- Studenter: genomströmning, studiebidrag med mera.

- Diversifiering: könsmässig och etnisk balans samt andelen internationella studenter.

- R-rank: universitet och utbildningar som liknar ”top-notch”-universitet.

De kriterier som Education Evaluation & Accreditation Council of Taiwan tillämpar är enklare och består av tre huvudkriterier:

- Forskningsproduktivitet: det vill säga både antalet artiklar de senaste elva åren och innevarande år.

- Forskningens genomslagskraft: citeringar både vad gäller elva år tillbaka och innevarande år.

- Forskningens excellens: baseras på antalet ”Highly Cited Papers” under de senaste två åren och hur ofta de publicerats i välrenommerade tidskrifter.

Det tredje kriteriet ges en vikt på 50 procent och stämmer alltså med Hammarfeldts notering att man i dag på vissa håll har börjat fästa stor vikt vid forskningens kvalitet och höga nivå internationellt.

Den rankning som Shanghai står för baseras på liknande kriterier som Taiwan och man använder sig av en strikt kvantitativ metodologi:

utbildningens kvalitet, fakultetens kvalitet, forskningsartiklar, forskningsciteringar samt storleken på universitetet är de valda kriterierna.

Det bör nämnas att utbildningens kvalitet utgår från hur många alumni som fått utmärkelser, typ Nobelpriset. Shanghais rankning delar också upp fakulteter på ett liknande sätt, dels baserat på utmärkelser men också baserat på citeringar. Storleken på institutionen är inte ett absolut mått på antalet anställda lärare, utan är en vägd kvot: summan av de ovan nämnda kriterierna delat med antalet heltidsanställda.

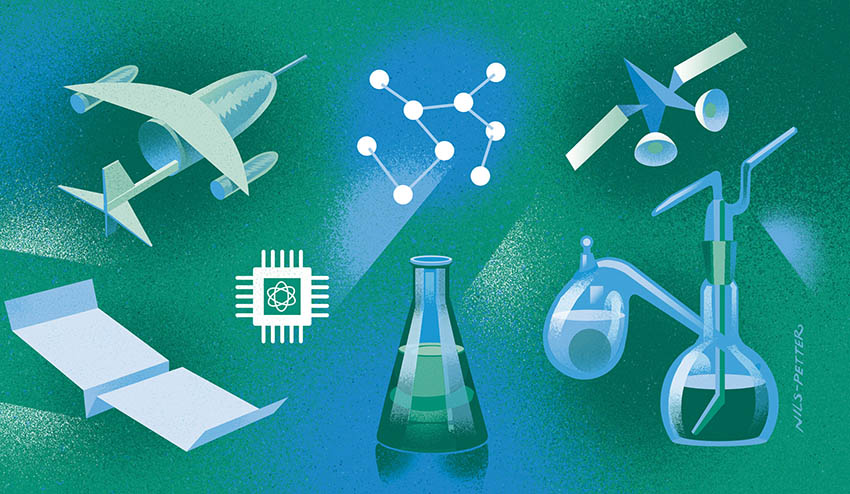

Båda de kinesiska rankningssystemen skiljer sig alltså från det amerikanska som tar hänsyn till både diversifiering och studentgenomströmning. Både i Kina och Taiwan tittar man således på det faktiska studieresultatet i form av forskningsartiklar, citeringar och utmärkelser, inte på rent sociala aspekter. Det finns även andra rankningsmetoder, men de utgår alla från liknande kriterier och använder antal publikationer, citeringar, utmärkelser och liknande kriterier för att nå fram till en rankning.

Bo Rothsteins uppmaning till svenska samhällsvetenskapliga forskare var att inrikta sig på en internationell publik och det är lätt att hålla med honom på den punkten. Hur ska man annars som forskare kunna hävda sitt behov av forskningsresurser om man enbart publicerat sig inom landet? Resten av forskarsamhället anpassar sig till en globaliserad värld, där allt hårdare konkurrens råder.

Det kan givetvis finnas problem med ett rent kvantitativt mått på forskningskvalitet. Ibland är det ju först efter decennier som de stora upptäckterna besannas. Publikationer med forskningsgenombrott räknas lika med mer ointressanta studier. Det är därför en verklig metodologisk utmaning att utveckla en rättvisande metod med vilken man kan jämföra universitet, fakulteter och enskilda institutioner.

Ändå är det oundvikligt att diskutera det rent metodologiska. Det är lätt att hålla med kritikerna av rankningssystem på en avgörande punkt: dagens rankningar baserar sig på mycket grova variabler och ger troligen en oförtjänt fördel för mer ärevördiga universitet och institutioner. Just därför borde man föreslå en metod som försöker eliminera denna eventuella orättvisa.

Ett preliminärt förslag är att oberoende bedömare granskar ett slumpmässigt urval av avhandlingar från olika institutioner, inte bara doktorsavhandlingar utan även masteruppsatser och liknande. När det gäller publicerade artiklar kan dessa åsättas olika vikt baserat på impact factors. Man bör betänka att kvalitet inte enkelt kan relateras till antal citeringar, då sensationella men i grunden missvisande resultat ju kan ge upphov till mängder av studier, som med tiden kan komma att falsifiera en ofta citerad studies resultat. Kvantitativt vinner i ett sådant fall den institution som stod bakom den sensationella publikationen, vilket är ett aber för metodutvecklare i rankningsbranschen.

När det gäller bedömningar av en universitetsinstitutions undervisning, borde det inte stöta på några hinder att låta studentskattningar ligga till grund för bedömningarna. Men man bör inte heller vara främmande för oberoende bedömningar av föreläsningar och val av kurslitteratur.

Universitet och institutioner som sedan länge kräver internationell publicering för erhållande av doktorsgraden har förstås ett försprång att hävda sig i de rankningssystem som i dag används. Det vore dock lätt för övriga att anpassa sig därvidlag.

För humaniora lär det behövas annorlunda bedömningsmetoder, men för ett stort antal samhällsvetenskapliga, medicinska och naturvetenskapliga institutioner torde det vara en rent mätmetodologisk fråga hur man väljer bedömningskriterier för vidare rankning.

Om vi alltså vill ha någon sorts motsvarighet till börsvärde på våra universitet, så gäller metodutveckling.

Sven-Erik Fernaeus, fil dr